Internet Matters est ravi de participer à cette consultation de bienvenue. Nous avons quelques remarques introductives qui encadrent notre réflexion avant d'entrer dans les questions spécifiques. Internet Matters existe pour aider les familles à bénéficier de la technologie connectée. Nous sommes une organisation à but non lucratif, financée par l'industrie Internet - et nous sommes heureux de réunir des marques de premier plan pour se concentrer sur la sécurité des enfants et le bien-être numérique. Nous fournissons des conseils d'experts aux parents, présentés de manière vraiment utilisable, par âge de l'enfant, par appareil, application, plateforme ou par problème.

Nous savons que s'engager avec notre contenu donne aux parents, aux tuteurs et de plus en plus aux professionnels la confiance et les outils dont ils ont besoin pour s'engager dans la vie numérique de ceux dont ils s'occupent. Avoir un adulte engagé dans la vie d'un enfant est le facteur le plus important pour garantir sa sécurité en ligne.Par conséquent, fournir à ces adultes les outils, les ressources et la confiance nécessaires pour agir est un élément fondamental de la littératie numérique.

Base réglementaire et complexités pour les parents

La directive SMAV découle du corpus juridique de l'UE qui repose sur le principe du «pays d'origine». En pratique, cela signifie, comme l'indique le document de consultation, que le cadre réglementaire provisoire couvrira 6 sites grand public et 2 sites de contenu pour adultes. Cela s'avérera très difficile à expliquer aux parents qui pourraient à juste titre s'attendre à ce que si le contenu est visible au Royaume-Uni, il soit réglementé au Royaume-Uni.

Tout en reconnaissant les limites de la directive SMAV, la consultation note à plusieurs reprises que dans la mesure où la future législation sur les dommages en ligne traitera du contenu inapproprié à l'âge, elle ne se sentira pas tenue d'honorer le principe du pays d'origine. C'est une position que nous approuvons. Si le contenu est visible au Royaume-Uni, il doit être conforme aux règles britanniques.

Cependant, il existe un décalage entre les objectifs déclarés du Livre blanc sur les dangers en ligne et le champ d'application de la directive SMAV. Le livre blanc parle en grande partie des plates-formes qui permettent la publication de contenu généré par les utilisateurs. La SMAV n'est pas limitée de cette manière. Dans ce cas, l'AVMSD a raison. Cela n'a aucun sens de limiter le champ d'application de la législation en ligne sur les dommages aux plates-formes qui permettent la publication de contenu généré par l'utilisateur. Ce qui compte, c'est la nature du contenu, pas comment ni par qui il a été produit.

Question 19: Quels sont les exemples d'utilisation et de mise en œuvre efficaces de l'une quelconque des mesures énumérées à l'article 28 (b) (3) de la Directive SMAV 2018? Les mesures sont les conditions générales, les mécanismes de signalement et de signalement, les systèmes de vérification de l'âge, les systèmes de classification, les systèmes de contrôle parental, les fonctions de plaintes faciles d'accès et la fourniture de mesures et d'outils d'éducation aux médias. Veuillez fournir des preuves et des exemples spécifiques pour étayer votre réponse.

Notre travail à l'écoute des familles informe tout ce que nous faisons - et étant donné que nous sommes un élément clé de la littératie numérique pour les parents, nous voulions partager quelques idées avec vous. Les parents demandent des conseils sur la sécurité en ligne lorsque l'une des quatre choses se produit:

- Il y a un nouvel appareil à la maison

- Il y a une nouvelle application / plate-forme sur l'appareil

- Les enfants commencent l'école secondaire

- Il y a un problème de sécurité qui peut être provoqué par un certain nombre de raisons, notamment l'expérience vécue, les invites de l'école, les articles des médias, etc.

Les parents cherchent de l'aide le plus souvent par le biais d'une recherche en ligne ou en demandant de l'aide à l'école. De toute évidence, tout au long du verrouillage, la recherche de solutions a été plus importante, ce qui signifie que les conseils fondés sur des preuves émanant d'organisations crédibles doivent être en tête du classement.

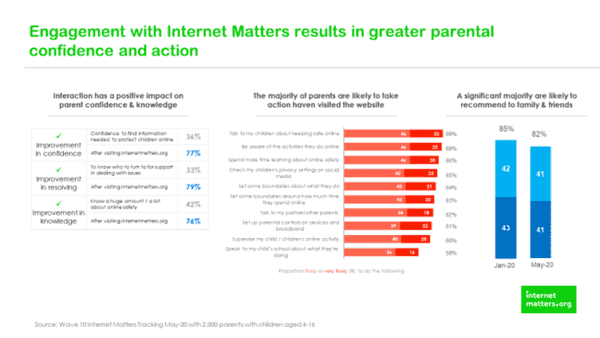

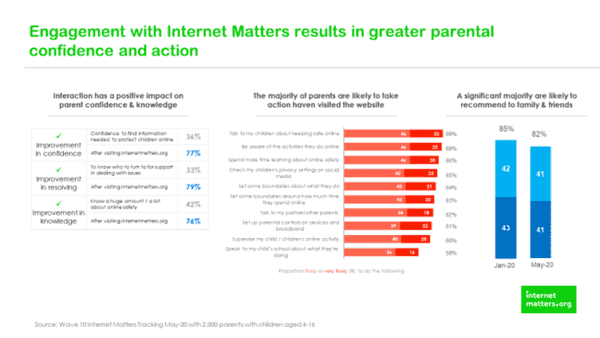

Une fois que les parents reçoivent des conseils, ils doivent être faciles à comprendre - et nous interrogeons donc régulièrement les parents pour savoir ce qu'ils pensent de parler et de faire différemment après avoir consulté notre site Web. Les graphiques ci-dessous démontrent que le fait de proposer aux parents un contenu qui répond à leurs besoins entraîne un changement significatif et mesurable.

Ces points de données indiquent que la littératie numérique des parents peut et est influencée par des ressources de bonne qualité - qui leur permettent d'avoir des conversations de routine avec leurs enfants sur leur vie numérique. De plus, nos pages sur le contrôle parental se classent systématiquement dans le top 10 des pages les plus populaires.

Question 20: Quels sont les exemples de mesures qui n'ont pas répondu aux attentes en matière de protection des utilisateurs et pourquoi? Veuillez fournir des preuves à l'appui de votre réponse dans la mesure du possible.

Nous devons conclure que la modération de la diffusion en direct ne fonctionne pas actuellement et ne peut peut-être pas fonctionner, l'abus des termes et conditions des plates-formes se produit en temps réel. Dans les deux exemples suivants, ce ne sont pas simplement les termes et conditions qui ont été abandonnés, c'était beaucoup plus grave. Le récent suicide tragique a été diffusé dans le monde entier en quelques secondes et bien que les plateformes aient pris des mesures rapides et décisives, trop de gens ont vu ce contenu déchirant sur les applications grand public, avec peu ou pas d'avertissement quant au contenu graphique. Comme nous le savons tous, ce n'était pas le seul exemple d'échec de la modération de la diffusion en direct, comme l'a souligné la fusillade de Christchurch en mars 2019.

De toute évidence, ce sont des problèmes complexes où quelqu'un entreprend délibérément de dévaster des vies par ses propres actions et sa décision de le diffuser en direct. Bien entendu, les deux exemples ne sont pas comparables, sauf dans ce que nous pouvons en tirer et ce qu'un régulateur pourrait faire de manière significative dans ces situations. C'est peut-être dans la nature très extrême et exceptionnelle de ce contenu que le confort peut être trouvé - en ce que dans presque toutes les autres circonstances, ce contenu est identifié et isolé dans les moments entre le téléchargement et le partage. De toute évidence, ce sont des décisions en une fraction de seconde qui reposent sur des algorithmes exceptionnels et des modérateurs humains qualifiés. Le rôle du régulateur dans cette situation est peut-être de travailler avec des plates-formes sur lesquelles un tel contenu peut être ou a été téléchargé et visualisé et partagé pour comprendre et explorer ce qui n'a pas fonctionné, puis convenir d'actions concrètes pour s'assurer que cela ne se reproduira plus. Peut-être que ces apprentissages pourraient être partagés par le régulateur de manière confidentielle avec d'autres plates-formes, simplement dans le but de s'assurer que les leçons sont tirées le plus largement possible - pour la protection du public et, le cas échéant, pour que l'entreprise fournisse des réparations. Pour cela, pour fonctionner, la culture du régulateur et son approche doivent être collaboratives et engageantes plutôt que distantes et punitives.

Les recommandations que le régulateur peut souhaiter déployer pourraient inclure (mais sans s'y limiter) que les entreprises qui en font la demande ont établi des plans pour travailler ensemble pour s'assurer que les notifications sont immédiatement partagées entre les plates-formes - car il n'y a aucun avantage commercial à conserver ces informations sur une seule plate-forme.

L'autre problème qui nécessite un examen détaillé concerne les commentaires sous les vidéos - que ce soit les tout-petits dans la pataugeoire ou la synchronisation labiale des adolescents avec des vidéos musicales. Il y a peut-être deux problèmes distincts ici. Pour les comptes des jeunes entre 13 et 16 ans, à moins que et jusqu'à ce que l'anonymat sur Internet n'existe plus, «les plateformes devraient être encouragées à adopter une approche prudente des commentaires, en supprimant tout ce qui est signalé et en les rétablissant une fois que le commentaire a été validé».

Nous encourageons le régulateur à continuer de travailler avec les plates-formes pour identifier les vidéos qui, bien qu'innocentes par nature, attirent les commentaires inappropriés et suspendent la possibilité de commenter publiquement sous celles-ci Souvent, les titulaires de compte n'ont aucune idée de qui les commentaires sont laissés et le contexte est tout. Un pair admirant un mouvement de danse ou un vêtement est matériellement différent des commentaires d'un étranger.

Tant que les sites ne sont pas tenus de vérifier l'âge des utilisateurs, les diffusions en direct seront à la fois téléchargées et regardées par les enfants. Les enfants ont autant droit aux technologies émergentes que quiconque - et doivent pouvoir les utiliser en toute sécurité. Ainsi, le défi pour le régulateur est de savoir comment garantir que les enfants qui diffusent en direct peuvent le faire sans contact inapproprié d'étrangers.

Alors que de nombreux jeunes nous disent qu'ils aiment et apprécient la validation qu'ils reçoivent des commentaires, la solution n'est pas de conserver la fonctionnalité. C'est pour l'arrêter et investir du temps et de l'argent pour comprendre ce qui se passe dans la vie de nos jeunes que la validation des étrangers est si significative pour eux.

Pour les parents qui publient des images de tout-petits dans des pataugeoires, il y a des réponses à la fois techniques et éducatives. Il devrait y avoir la possibilité que les images ne soient vues qu'en mode privé afin que les étrangers ne puissent pas commenter. Deuxièmement, il devrait y avoir une pièce de théâtre éducative pour les parents - qui commence probablement par des conversations entre la future mère et la sage-femme sur la part de la vie infantile de leur enfant qu'il est approprié de publier en ligne pour que le monde le voie. Le régulateur pourrait jouer un rôle dans la remise en question du style de vie de spectacle qui est rapidement devenu la norme.

Question 21: Quels indicateurs de préjudice potentiel l'Ofcom devrait-il connaître dans le cadre de ses activités de surveillance et de conformité permanentes sur les services VSP? Veuillez fournir des preuves à l'appui de votre réponse dans la mesure du possible.

Au cours des 18 derniers mois, Internet Matters a investi beaucoup de temps et de ressources pour comprendre l'expérience en ligne des enfants vulnérables - en particulier en quoi elle diffère de celle de leurs pairs non vulnérables. Notre rapport Les enfants vulnérables dans un monde numérique publié en février 2019 a démontré que les enfants vulnérables vivent une expérience en ligne sensiblement différente. Des recherches plus poussées démontrent que les enfants et les jeunes atteints de SEND sont particulièrement à risque car ils sont moins capables d'évaluer de manière critique les risques de contact et plus susceptibles de croire que les gens sont ce qu'ils prétendent être. De même, les enfants bénéficiant de soins sont plus à risque de voir du contenu préjudiciable, en particulier autour du contenu d'automutilation et de suicide. Il existe de nombreux autres exemples.

Le point ici n'est pas que les jeunes vulnérables devraient avoir une expérience distincte s'ils s'identifient aux plateformes, mais plus que le régulateur et les plateformes reconnaissent qu'il y a des millions d'enfants vulnérables au Royaume-Uni qui ont besoin d'un soutien supplémentaire pour bénéficier de la technologie connectée. La nature du soutien variera mais comprendra inévitablement des interventions d'alphabétisation numérique supplémentaires et sur mesure ainsi qu'une meilleure modération du contenu pour supprimer le contenu dangereux avant qu'il ne soit partagé.

Les données du Cybersurvey 2019 de Youthworks en partenariat avec Internet Matters indiquent:

- Les jeunes sont de plus en plus exposés à des contenus préjudiciables parlant de suicide ou d'automutilation. En 2019, un quart des adolescents interrogés avaient déjà vu du contenu parlant de suicide et 13% avaient vu du contenu sur l'automutilation. En 2015, 11% avaient déjà vu du contenu encourageant l'automutilation ou le suicide

- Le pourcentage de victimes d'intimidation ou d'agression raciste personnellement en ligne en 2019 est plus élevé qu'en 2015; 13% contre 4%

- Le pourcentage de personnes ayant personnellement été victimes d'intimidation ou d'agression homophobe en ligne en 2019 est près de quatre fois plus élevé qu'en 2015; 15% contre 4%

- Le risque de contenu est plus courant que le risque de contact:

- Le contenu pro-anorexie, que nous avons signalé dans plusieurs rapports précédents de Cybersurvey, est rejoint cette année par un contenu encourageant les adolescents à `` gonfler votre corps ''. Ceci est largement vu, principalement par les garçons. (Bien que l'aptitude physique soit positive, le gonflement peut être nocif si, pour y parvenir, un jeune est encouragé à utiliser des substances qui peuvent ne pas être aussi étiquetées)

Le contenu sur l'automutilation est vu `` souvent '' par des adolescents déjà vulnérables, en particulier ceux qui ont un trouble de l'alimentation (23%) ou des difficultés d'élocution (29%), alors que seulement 9% des jeunes sans vulnérabilité l'ont `` jamais '' vu et seulement 2% l'ont fait «souvent».

Question 22: La directive SMAV 2018 oblige les PSV à prendre des mesures appropriées pour protéger les mineurs contre les contenus qui `` peuvent nuire à leur développement physique, mental ou moral ''. Quels types de contenu considérez-vous comme pertinents dans ce cadre? Quelles mesures considérez-vous les plus appropriées pour protéger les mineurs? Veuillez fournir des preuves à l'appui de votre réponse dans la mesure du possible, y compris des considérations liées à l'âge.

En plus du contenu d'automutilation et de suicide détaillé dans notre réponse à la question 21, il existe plusieurs autres types de contenu qui peuvent nuire au développement physique, mental ou moral des enfants, notamment (et sans s'y limiter)

- Pornographie et tous les autres contenus pour adultes et sexualisés qui entourent la pornographie. Cela comprend également l'impact de ce contenu sur les perceptions des enfants sur les relations saines, le consentement et le rôle des femmes. Notre rapport - Nous devons parler de pornographie détaille ces problèmes dans le cadre de l'assistance parentale pour la vérification de l'âge

- Violence - la normalisation de la violence et les implications du contenu autour de certains types de musique et de culture de gang peuvent être très préjudiciables

- Activité criminelle - de l'utilisation de VSP pour recruter des mineurs pour les limites du comté et la glorification de modes de vie glamour, il existe une gamme de contenus préjudiciables qui encourage la criminalité

- Le jeu, le tabagisme et l'alcool, les couteaux - les enfants ne devraient pas pouvoir jouer en ligne - c'est illégal hors ligne et devrait être à la fois illégal et impossible en ligne. De même, il existe des restrictions d'âge pour la vente d'articles soumis à des restrictions; du tabac, de l'alcool et des armes et cela devrait signifier qu'il est impossible pour les enfants de revoir ce contenu sous la forme d'une publicité qui le glamourise ou se voit offrir la possibilité de l'acheter

- Idéologie / radicalisation / extrémisme - Bien que nous ne cherchions pas à limiter la liberté d'expression, les enfants et les jeunes méritent des protections spéciales afin qu'ils ne soient pas soumis à une idéologie et à un contenu radicaux et extrêmes

Peut-être que la façon d'envisager cela est de revoir et de mettre à jour les catégories de contenu que les fournisseurs d'accès Internet utilisent pour bloquer le contenu via les filtres de contrôle parental. Tout le contenu généré par l'utilisateur doit être soumis aux mêmes restrictions pour les enfants. Ce qui compte pour la santé et le bien-être des enfants, c'est le contenu lui-même, et non le fait que le contenu ait été créé par un radiodiffuseur grand public ou par quelqu'un d'autre.

Quelles mesures sont les plus appropriées pour protéger les mineurs?

- Restreint, certains contenus ne doivent tout simplement pas être diffusés à certains publics

- Utilisation accrue des avertissements sur l'écran de démarrage pour identifier le contenu légal mais préjudiciable

- Des actions plus draconiennes contre les utilisateurs qui créent du contenu qui enfreint les conditions générales des plateformes

- Vérification de l'âge pour le contenu réservé aux adultes et assurance d'âge pour les utilisateurs âgés de 13 à 16 ans

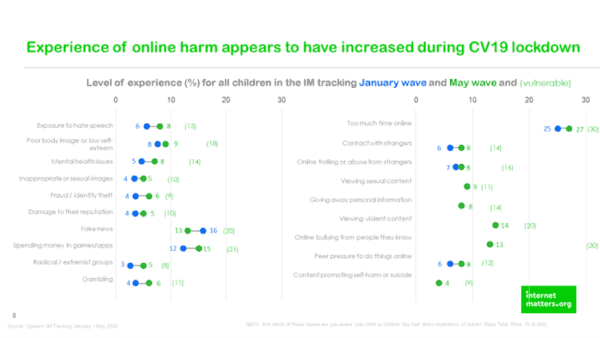

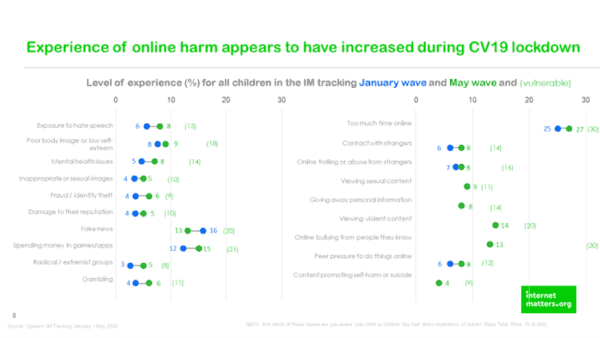

Il y a urgence à cela car nos données montrent que les expériences de préjudice en ligne ont augmenté pendant le verrouillage.

Question 23: Quels défis les fournisseurs de VSP pourraient-ils rencontrer dans l'adoption pratique et proportionnée de mesures dont l'Ofcom devrait être conscient? Nous serions particulièrement intéressés par votre raisonnement sur les facteurs pertinents pour l'évaluation de l'aspect pratique et de la proportionnalité.

Il peut être utile de faire ici une distinction entre le contenu illégal, où il existe des exigences très claires, et le contenu légal mais préjudiciable, où règne un monde de confusion.

Il s'agit d'un problème grave et complexe qui nécessitera un travail important entre les plateformes et le régulateur pour être résolu. Étant donné que le gouvernement a l'intention de nommer l'Ofcom en tant que régulateur des dommages en ligne, il y aura autant d'intérêt à la manière dont cela est fait qu'à ce que cela soit fait. Des précédents allons-nous établir et des attentes créées.

Question 24: Comment les VSP devraient-ils équilibrer les droits de leurs utilisateurs à la liberté d'expression et quelles mesures devraient-ils utiliser pour surveiller cela? Quel rôle voyez-vous pour un régulateur?

- Clarté des directives communautaires sur ce qui est approprié et non et ce qui sera acceptable / toléré. Abusez-le et c'est parti. La liberté d'expression n'est pas restreinte parce que vous pourriez trouver une autre plate-forme pour exprimer ces opinions - mais elles ne sont pas acceptables sur celle-ci

- Mesures - prévalence, retraits et rapports

- Le rôle du régulateur est de s'assurer que les normes communautaires sont appliquées, de reconnaître que, comme pour toutes les règles, les gens vont les pousser et les contourner, donc un élément de modération humaine et de bon sens est également requis.

- Le régulateur doit reconnaître que l'éducation est également un élément clé de cela, de sorte que les PSV qui investissent dans des programmes d'éducation indépendants qui améliorent la littératie numérique doivent être encouragés / considérés favorablement / bénéficiant d'une réduction de taxe.

Question 25: Comment les VSP devraient-ils prévoir un mécanisme de recours extrajudiciaire pour le règlement impartial des différends entre les utilisateurs et les fournisseurs de VSP? (voir point 2.32 et article 28 (b) (7) en annexe 5). Veuillez fournir des preuves ou une analyse pour étayer votre réponse dans la mesure du possible, y compris une réflexion sur la manière dont cette exigence pourrait être satisfaite de manière efficace et proportionnée.

Internet Matters n'a pas commenté cette question

Question 26: Comment l'Ofcom pourrait-il aider au mieux les VSP à continuer d'innover pour assurer la sécurité des utilisateurs?

- Reconnaître les investissements et les interventions hors application dans la culture médiatique / numérique qui peuvent démontrer leur impact grâce à une évaluation solide

- Veiller à ce qu'ils reconnaissent que la conformité va au-delà de la suppression de contenu - comme dans le modèle irlandais, elle doit inclure des mesures pour minimiser la propagation et l'amplification des contenus préjudiciables

- Soyez clair sur l'intention des exigences - là où, toujours selon le modèle irlandais, il y a un cycle de minimisation des dommages par lequel le nombre de personnes exposées à des contenus préjudiciables est significativement réduit au fil du temps en conséquence directe des mesures prises

- Rendez la création de rapports sur le contenu aussi simple que le téléchargement de contenu et tenez les journalistes informés des processus et des délais de résolution probables. Cela devrait inclure des temps de réponse clairement publiés, conformes à une norme minimale et tenir les utilisateurs informés. De plus, nous soupçonnons qu'une partie du libellé entourant le signalement du contenu est décourageant pour les enfants, alors suggérons qu'un travail soit fait pour identifier le libellé et le processus les plus appropriés pour les jeunes afin qu'ils soient plus susceptibles de signaler ce contenu. De plus, les plates-formes doivent faire un effort soutenu pour restaurer la confiance dans leurs mécanismes de signalement afin que les utilisateurs de tous âges croient que quelque chose se passera s'ils font un rapport.

- Facilitez la création de rapports pour les mineurs - alors testez avec eux la manière la plus appropriée de le faire par la plateforme. Un langage complexe et spécifique est-il préférable pour les jeunes, ou un langage plus doux comme «je n'aime pas ça» ou «ce contenu me rend malheureux» serait-il plus efficace? De plus, hiérarchisez leurs préoccupations et essayez peut-être ce qui se passe si les signalements de mineurs sont supprimés, puis examinés et rétablis si nécessaire. Si nous voulions vraiment faire d'Internet un endroit sûr pour les enfants, nous nous concentrerions sur leurs besoins - sur les plateformes qu'ils sont susceptibles de fréquenter

Question 27: Comment l'Ofcom peut-il au mieux aider les entreprises à se conformer aux nouvelles exigences?

- Reconnaître les limites de la portée et du calendrier des exigences - et les signaler en conséquence. Si les règlements ne s'appliquent qu'à 6 ou 8 organisations, ne faites pas de demande excessive - elles ne seront pas des leaders mondiaux. Ceci est important pour que les parents soient réalistes sur les changements que les exigences entraîneront et ne deviendront pas moins vigilants parce qu'ils croient qu'il existe une solution réglementée

- Reconnaissez que la taille n'est pas une condition préalable à l'existence du risque et du préjudice, et que dans tous les autres domaines des produits de consommation, les entreprises ne peuvent pas mettre sur le marché des produits moins sûrs ou plus risqués parce qu'ils sont petits. Les micro-brasseries ont la même obligation légale de se conformer à toutes les réglementations appropriées en matière de santé et de sécurité que Coca-Cola. Il en va de même pour les fabricants de jouets et les producteurs de films. Le droit d'être en sécurité ou, dans ce cas, de ne pas être lésé est absolu et ne dépend pas de la taille de l'organisation à partir de laquelle vous consommez un produit ou un service

Question 28: Avez-vous des opinions sur l'ensemble de principes énoncés au paragraphe 2.49 (protection et assurance, liberté d'expression, adaptabilité dans le temps, transparence, application robuste, indépendance et proportionnalité) et équilibrer les tensions qui peuvent parfois survenir entre leur?

- Les propositions irlandaises reconnaissent qu'il s'agit d'un processus itératif, alors soyez les bienvenus pour être agile et innovant. L'objectif de la réglementation en conformité avec les codes, plutôt que le comportement personnel - mais il faut encore un endroit pour éduquer afin que le comportement soit abordé. La consultation actuelle de la Commission des lois sur les crimes en ligne est également une intervention intéressante ici, car de telles modifications de la loi créeront une clarté juridique et donc culturelle sur ce qui est acceptable et un comportement légal en ligne.

- Les problèmes de liberté d'expression et d'expression peuvent être traités par des termes et conditions - il peut donc y avoir un endroit où vos opinions extrêmes sont les bienvenues - mais ce n'est pas la plate-forme appropriée pour cela. Ne suggérant pas que vous ne pouvez pas exprimer ces points de vue, mais déclarant simplement que vous ne pouvez pas le faire sur cette plateforme

- Reconnaissance des défis de la vérification de l'âge des mineurs et des marges d'erreur dans l'assurance de l'âge et des limites inévitables de ces technologies