A Internet Matters tem o prazer de participar desta consulta bem-vinda. Temos alguns comentários introdutórios que enquadram nosso pensamento antes de entrarmos nas questões específicas. A Internet Matters existe para ajudar as famílias a se beneficiarem da tecnologia conectada. Somos uma organização sem fins lucrativos, fundada pela indústria da Internet - e temos o prazer de reunir marcas líderes para focar na segurança infantil e no bem-estar digital. Oferecemos conselhos especializados aos pais, apresentados de uma forma realmente útil, por idade da criança, por dispositivo, aplicativo, plataforma ou por problema.

Sabemos que o envolvimento com nosso conteúdo dá aos pais, responsáveis e cada vez mais profissionais a confiança e as ferramentas de que precisam para se envolverem com a vida digital de quem cuidam. Ter um adulto engajado na vida de uma criança é o fator mais importante para garantir que ela esteja segura online, portanto, fornecer a esses adultos as ferramentas, recursos e confiança para agir é uma parte fundamental da alfabetização digital.

Base regulatória e complexidades para os pais

O AVMSD deriva do corpo legislativo da UE que se baseia no princípio do “país de origem”. Na prática, isso significa que, como afirma o documento de consulta, o quadro regulamentar provisório abrangerá 6 sites convencionais e 2 sites de conteúdo adulto. Isso será muito difícil de explicar aos pais que poderiam, com razão, esperar que, se o conteúdo puder ser visualizado no Reino Unido, ele será regulamentado no Reino Unido.

Embora reconheça as limitações do AVMSD, a consulta observa repetidamente que, na medida em que a legislação contra danos on-line abordará conteúdo impróprio para idade, ela não se sentirá obrigada a honrar o princípio do país de origem. Esta é uma posição que endossamos. Se o conteúdo puder ser visualizado no Reino Unido, ele deve estar em conformidade com as regras do Reino Unido.

No entanto, há um desalinhamento entre os objetivos declarados do White Harms White Paper e o escopo do AVMSD. O White Paper fala amplamente sobre plataformas que permitem a publicação de conteúdo gerado pelo usuário. O AVMSD não está limitado dessa forma. Neste caso, o AVMSD acertou. Não faz sentido limitar o escopo da legislação sobre danos on-line a plataformas que permitem a publicação de conteúdo gerado pelo usuário. O que importa é a natureza do conteúdo, não como ou por quem foi produzido.

Pergunta 19: Que exemplos existem de uso e implementação eficazes de qualquer uma das medidas listadas no artigo 28 (b) (3) do AVMSD 2018? As medidas são termos e condições, mecanismos de sinalização e relatório, sistemas de verificação de idade, sistemas de classificação, sistemas de controle dos pais, funções de reclamação de fácil acesso e o fornecimento de medidas e ferramentas de alfabetização midiática. Forneça evidências e exemplos específicos para apoiar sua resposta.

Nosso trabalho de ouvir as famílias informa tudo o que fazemos - e, como somos uma parte importante no fornecimento de alfabetização digital para pais, gostaríamos de compartilhar alguns insights com você. Os pais procuram aconselhamento sobre segurança online quando uma das quatro coisas acontece:

- Há um novo dispositivo em casa

- Há um novo aplicativo / plataforma no dispositivo

- As crianças começam a escola secundária

- Existe uma preocupação com a segurança que pode ser motivada por uma série de razões, incluindo experiências vividas, sugestões da escola, histórias da mídia, etc.

Os pais procuram ajuda com mais frequência por meio de uma pesquisa online ou pedindo ajuda na escola. Claramente, durante o bloqueio, a busca por soluções tem sido mais importante, o que significa que os conselhos baseados em evidências de organizações confiáveis devem estar no topo das classificações.

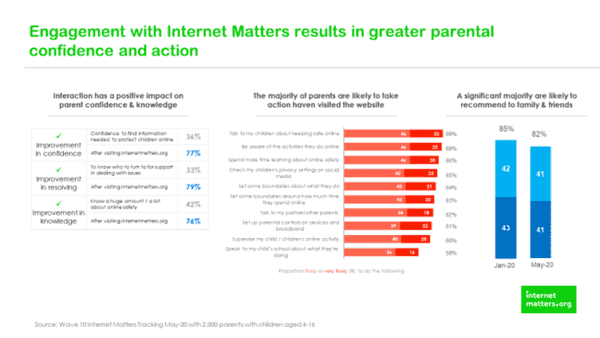

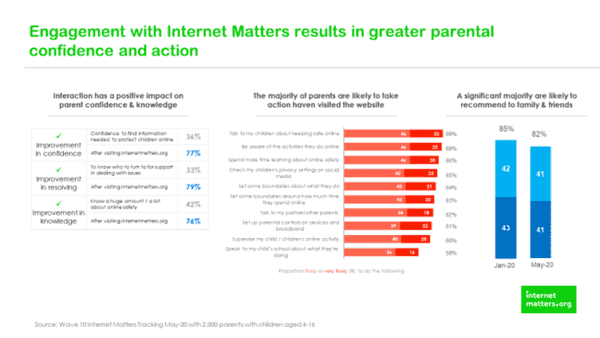

Uma vez que os pais estão engajados com o conselho, ele deve ser fácil de entender - então, regularmente fazemos pesquisas com os pais sobre o que eles acham que falam e fazem de diferente depois de entrarem em contato com nosso site. Os gráficos abaixo demonstram que servir aos pais um conteúdo que atenda aos seus requisitos leva a mudanças significativas e mensuráveis.

Esses dados indicam que a alfabetização digital entre os pais pode e é influenciada por recursos de boa qualidade - que os equipam para ter conversas rotineiras com seus filhos sobre suas vidas digitais. Além disso, nossas páginas sobre controle dos pais são classificadas de maneira consistente entre as 10 páginas mais populares.

Questão 20: Quais são os exemplos de medidas que ficaram aquém das expectativas em relação à proteção dos usuários e por quê? Sempre que possível, forneça evidências para apoiar sua resposta.

Temos que concluir que a moderação de streaming ao vivo não está funcionando atualmente e talvez não possa funcionar, o abuso dos termos e condições das plataformas acontece em tempo real. Nos dois exemplos a seguir, não foram simplesmente os termos e condições que foram abandonados, foi muito mais sério. O trágico suicídio recente circulou globalmente em segundos e, embora as plataformas tenham tomado uma ação rápida e decisiva, muitas pessoas viram aquele conteúdo angustiante em aplicativos convencionais, com pouco ou nenhum aviso quanto ao conteúdo gráfico. Como todos sabemos, este não foi o único exemplo de falha de moderação da transmissão ao vivo, como destacado no tiroteio de Christchurch em março de 2019.

Claramente, essas são questões complexas em que alguém deliberadamente se propõe a devastar vidas por meio de suas próprias ações e sua decisão de transmitir isso ao vivo. Obviamente, os dois exemplos não são comparáveis, exceto no que podemos aprender com eles e no que um regulador poderia fazer de forma significativa nessas situações. Talvez seja na natureza extrema e excepcional desse conteúdo que o conforto pode ser encontrado - em quase todas as outras circunstâncias, esse conteúdo é identificado e isolado nos momentos entre o upload e o compartilhamento. Claramente, essas são decisões em frações de segundos que dependem de algoritmos excelentes e moderadores humanos qualificados. Talvez o papel do regulador nessa situação seja trabalhar com plataformas nas quais esse conteúdo pode ser ou foi carregado, visualizado e compartilhado para entender e explorar o que deu errado e, então, concordar com ações concretas para garantir que isso não aconteça novamente. Talvez essas aprendizagens possam ser compartilhadas pelo regulador de forma confidencial com outras plataformas, simplesmente com o propósito de garantir que as lições sejam aprendidas o mais amplamente possível - para a proteção do público e, quando apropriado, para a empresa fornecer reparação. Para isso, para trabalhar a cultura do regulador e sua abordagem tem que ser colaborativa e envolvente, ao invés de remota e punitiva.

As recomendações que o regulador pode querer implantar podem incluir (mas não se limitar a) empresas solicitantes que tenham planos estabelecidos para trabalharem juntas para garantir que as notificações sejam compartilhadas imediatamente entre as plataformas - já que não há vantagem comercial em manter essas informações em uma plataforma.

A outra questão que requer consideração detalhada são os comentários nos vídeos - sejam crianças pequenas na piscina ou adolescentes dublando os vídeos de música. Talvez haja dois problemas separados aqui. Para relatos de jovens entre 13 e 16 anos, a menos e até que o anonimato na Internet não exista mais, 'as plataformas devem ser incentivadas a ter uma abordagem cautelosa aos comentários, removendo tudo o que é relatado e reintegrando assim que o comentário tiver sido validado.'

Incentivamos o regulador a continuar a trabalhar com plataformas para identificar vídeos que, embora de natureza inocente, atraem comentários inadequados e suspendem a capacidade de comentar publicamente sob eles. Muitas vezes, os titulares de contas não têm ideia de quem os comentários estão sendo deixados e o contexto é tudo. Um colega admirando um movimento de dança ou uma peça de roupa é materialmente diferente dos comentários de um estranho.

Enquanto os sites não precisarem verificar a idade dos usuários, as transmissões ao vivo serão carregadas e assistidas por crianças. As crianças têm tanto direito à tecnologia emergente quanto qualquer outra pessoa - e devem ser capazes de usá-la com segurança. Portanto, o desafio para o regulador passa a ser como garantir que as crianças que estão transmitindo ao vivo possam fazer isso sem o contato impróprio de estranhos.

Embora muitos jovens nos digam que gostam e apreciam a validação que recebem dos comentários, a solução não é reter a funcionalidade. É para parar com isso e investir tempo e dinheiro na compreensão do que está acontecendo na vida de nossos jovens que a validação de estranhos é tão significativa para eles.

Para os pais que publicam imagens de crianças pequenas em piscinas infantis, há respostas técnicas e educacionais. Deve haver a possibilidade de as imagens serem vistas apenas no modo privado, para que estranhos não possam comentar. Em segundo lugar, deve haver uma peça educativa para os pais - que provavelmente começa com conversas entre a futura mãe e a parteira sobre quanto da vida infantil de seu filho é apropriado postar online para o mundo ver. O regulador pode desempenhar um papel no desafio ao estilo de vida show-reel que rapidamente se tornou a norma.

Pergunta 21: Quais indicadores de dano potencial o Ofcom deve estar ciente como parte de suas atividades contínuas de monitoramento e conformidade nos serviços VSP? Sempre que possível, forneça evidências para apoiar sua resposta.

Nos últimos 18 meses, Internet Matters investiu uma quantidade significativa de tempo e recursos para entender a experiência online de crianças vulneráveis - especificamente como ela difere de seus colegas não vulneráveis. Nosso relatório Crianças vulneráveis no mundo digital publicado em fevereiro de 2019, demonstrou que crianças vulneráveis têm uma experiência on-line bastante diferente. Pesquisas adicionais demonstram que crianças e jovens com SEND correm um risco particular, pois são menos capazes de avaliar criticamente os riscos de contato e mais propensos a acreditar que as pessoas são quem dizem ser. Da mesma forma, crianças com experiência de cuidado correm mais risco de ver conteúdo prejudicial, especialmente em relação a conteúdo de automutilação e suicídio. Há muitos mais exemplos.

O ponto aqui não é que os jovens vulneráveis devem ter uma experiência separada se eles se identificarem com as plataformas, mas mais do que o regulador e as plataformas reconhecem que existem milhões de crianças vulneráveis no Reino Unido que precisam de apoio adicional para se beneficiar da tecnologia conectada. A natureza do suporte irá variar, mas inevitavelmente incluirá intervenções de alfabetização digital adicionais e sob medida, bem como melhor moderação de conteúdo para remover conteúdo perigoso antes de ser compartilhado.

Dados do Cybersurvey 2019 da Youthworks em parceria com a Internet Matters indicam:

- Os jovens estão cada vez mais expostos a conteúdos nocivos que falam sobre suicídio ou automutilação. Em 2019, um quarto dos adolescentes entrevistados já tinha visto conteúdo falando sobre suicídio e 13% tinha visto conteúdo sobre automutilação. Em 2015, 11% já tinham visto conteúdo incentivando a automutilação ou o suicídio

- A porcentagem de pessoas que sofreram bullying ou agressão racista pessoalmente online em 2019 é maior do que em 2015; 13% em comparação com 4%

- A porcentagem de pessoas que experimentaram pessoalmente bullying homofóbico ou agressão online em 2019 é quase quatro vezes maior do que em 2015; 15% em comparação com 4%

- O risco de conteúdo é mais comumente experimentado do que o risco de contato:

- O conteúdo pró-anorexia, que sinalizamos em vários relatórios anteriores da pesquisa cibernética, se juntou este ano ao conteúdo que incentiva os adolescentes a "aumentar o volume do seu corpo". Isso é amplamente visto, principalmente por meninos. (Embora o condicionamento físico seja positivo, aumentar a massa muscular pode ser prejudicial se, para isso, um jovem for incentivado a usar substâncias que podem não estar nos rótulos)

O conteúdo sobre automutilação é visto "frequentemente" por adolescentes já vulneráveis, especialmente aqueles com transtorno alimentar (23%) ou dificuldades de fala (29%), enquanto apenas 9% dos jovens sem vulnerabilidades o viram "alguma vez" e apenas 2% o fizeram 'frequentemente'.

Pergunta 22: O AVMSD 2018 exige que os VSPs tomem as medidas adequadas para proteger os menores de conteúdo que 'pode prejudicar seu desenvolvimento físico, mental ou moral'. Que tipo de conteúdo você considera relevante neste contexto? Que medidas considera mais adequadas para proteger os menores? Sempre que possível, forneça evidências para apoiar sua resposta, incluindo quaisquer considerações relacionadas à idade.

Além do conteúdo de automutilação e suicídio detalhado em nossa resposta à pergunta 21, existem vários outros tipos de conteúdo que podem prejudicar o desenvolvimento físico, mental ou moral das crianças, o que inclui (e não está limitado a)

- Pornografia e todos os outros conteúdos adultos e sexualizados que cercam a pornografia. Isso também inclui o impacto que este conteúdo tem nas percepções das crianças sobre relacionamentos saudáveis, consentimento e o papel das mulheres. Nosso relatório - Precisamos falar sobre pornografia detalha esses problemas no contexto do apoio dos pais para verificação de idade

- Violência - a normalização da violência e as implicações do conteúdo em torno de certos tipos de música e cultura de gangue podem ser altamente prejudiciais

- Atividade criminosa - desde o uso de VSP para recrutar menores para limites de condado e glorificação de estilos de vida glamorosos, há uma gama de conteúdo prejudicial que incentiva a criminalidade

- Jogos de azar, fumo e álcool, facas - as crianças não devem poder jogar online - é ilegal offline e deve ser ilegal e impossível online. Da mesma forma, existem restrições de idade para a venda de itens restritos; tabaco, álcool e armas e isso deve significar que é impossível para as crianças avaliarem este conteúdo na forma de um anúncio que o glamourize ou que seja apresentada a uma oportunidade de comprá-lo

- Ideologia / Radicalização / Extremismo - Embora não procuremos limitar a liberdade de expressão, as crianças e os jovens merecem proteções especiais para que não sejam sujeitos a ideologia e conteúdo radicais e extremos

Talvez a maneira de considerar isso seja revisar e atualizar as categorias de conteúdo que os Provedores de Serviços de Internet usam para bloquear conteúdo por meio dos filtros de controle dos pais. Todo conteúdo gerado pelo usuário deve estar sujeito às mesmas restrições para crianças. O que importa para a saúde e o bem-estar das crianças é o conteúdo em si, não se o conteúdo foi criado por uma emissora convencional ou alguém no futuro.

Que medidas são mais adequadas para proteger os menores?

- Restrito, alguns conteúdos não devem ser veiculados para alguns públicos

- Maior uso de avisos da tela inicial para identificar conteúdo legal, mas prejudicial

- Ações mais draconianas contra usuários que criam conteúdo que quebra os termos e condições da plataforma

- Verificação de idade para conteúdo adulto e garantia de idade para usuários de 13 a 16 anos

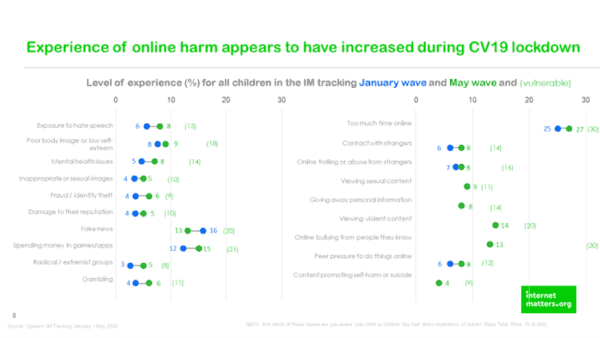

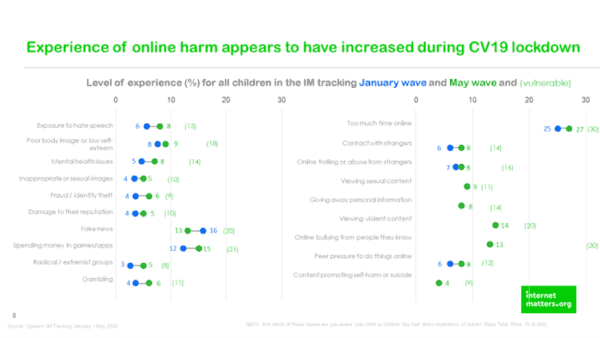

Há uma urgência nisso, pois nossos dados mostram que as experiências de danos on-line aumentaram durante o bloqueio.

Pergunta 23: Que desafios os provedores de VSP podem enfrentar na adoção prática e proporcional de medidas das quais o Ofcom deve estar ciente? Estaríamos particularmente interessados em seu raciocínio sobre os fatores relevantes para a avaliação da praticidade e da proporcionalidade.

Pode ser útil fazer uma distinção aqui entre conteúdo ilegal, onde há requisitos muito claros, e conteúdo legal, mas prejudicial, onde há um mundo de confusão

Este é um problema sério e complexo que exigirá um trabalho significativo entre as plataformas e o regulador para ser resolvido. Dado que o governo pretende nomear a Ofcom como Regulador de Danos Online, haverá tanto interesse em como isso é feito quanto em como isso é feito. Vamos definir precedentes e criar expectativas.

Pergunta 24: Como os VSPs devem equilibrar os direitos de seus usuários à liberdade de expressão e que métricas eles devem usar para monitorar isso? Que papel você vê para um regulador?

- Clareza nas diretrizes da comunidade sobre o que é apropriado ou não e o que será aceitável / tolerado. Abuse e você está pronto. A liberdade de expressão não é restringida porque você poderia encontrar outra plataforma para expressar esses pontos de vista - mas eles não são aceitáveis neste

- Métricas - prevalência, remoções e relatórios

- O papel do regulador é garantir que os padrões da comunidade sejam cumpridos, reconhecer que, como acontece com todas as regras, as pessoas as empurram e evitam, portanto, um elemento de moderação humana e bom senso também é necessário

- O regulador precisa reconhecer que a educação é uma parte importante disso também, então os VSPs que investem em programas de educação independente que aumentam a alfabetização digital devem ser encorajados / vistos com bons olhos / receber um desconto na taxa

Pergunta 25: Como os VSPs devem fornecer um mecanismo de reparação extrajudicial para a solução imparcial de disputas entre usuários e fornecedores de VSP? (ver ponto 2.32 e artigo 28.º, alínea b), n.º 7, no anexo 5). Sempre que possível, forneça evidências ou análises para apoiar sua resposta, incluindo considerações sobre como esse requisito pode ser atendido de forma eficaz e proporcional.

Internet Matters não tem comentários sobre esta questão

Pergunta 26: Qual a melhor maneira de o Ofcom oferecer suporte aos VSPs para continuar a inovar e manter os usuários seguros?

- Reconhecer investimentos e intervenções fora do aplicativo em mídia / alfabetização digital que podem demonstrar impacto por meio de avaliação robusta

- Certifique-se de que eles reconhecem que conformidade é mais do que remoção de conteúdo - como no modelo irlandês, deve incluir medidas para minimizar a disseminação e amplificação de conteúdo prejudicial

- Seja claro sobre a intenção dos requisitos - onde, novamente de acordo com o modelo irlandês, há um ciclo de minimização de danos em que o número de pessoas expostas a conteúdo nocivo é significativamente reduzido ao longo do tempo, como resultado direto das medidas tomadas

- Torne o relato de conteúdo preocupante tão fácil quanto o upload de conteúdo e mantenha os repórteres cientes dos processos e prováveis prazos de resolução. Isso deve incluir tempos de resposta claramente publicados que atendam a um padrão mínimo e mantenham os usuários informados. Além disso, suspeitamos que parte do texto em torno do conteúdo do relatório é desanimador para as crianças, portanto, sugira que algum trabalho seja feito para identificar o texto e o processo mais adequados para os jovens, de modo que tenham maior probabilidade de sinalizar esse conteúdo. Além disso, deve haver um esforço sustentado por parte das plataformas para restaurar a confiança em seus mecanismos de relatório, para que usuários de todas as idades acreditem que algo acontecerá se fizerem um relatório

- Facilite os relatórios para menores - teste com eles a maneira mais adequada de fazer isso pela plataforma. Uma linguagem complexa e específica é melhor para os jovens ou uma linguagem mais suave como "Não gosto disso" ou "este conteúdo me deixa infeliz" seria mais eficaz? Além disso, priorize suas preocupações e, talvez, teste o que acontece se os relatórios de menores forem removidos e, em seguida, examinados e reintegrados, se necessário. Se realmente quiséssemos tornar a Internet um lugar seguro para as crianças, nos concentraríamos em suas necessidades - nas plataformas que elas provavelmente frequentarão

Questão 27: Qual é a melhor maneira de o Ofcom apoiar as empresas a cumprir os novos requisitos?

- Reconheça as limitações no escopo e no tempo dos requisitos - e envie uma mensagem de acordo. Se os regulamentos se aplicarem apenas a 6 ou 8 organizações, não exagere - elas não serão líderes mundiais. Isso é importante para que os pais sejam realistas sobre as mudanças que os requisitos trarão e não se tornem menos vigilantes porque acreditam que existe uma solução regulamentada

- Reconheça que o tamanho não é um pré-requisito para a existência de riscos e danos e que em todos os outros domínios de produtos de consumo as empresas não podem colocar produtos menos seguros ou mais arriscados no mercado porque são pequenos. As microcervejarias têm os mesmos requisitos legais para cumprir todos os regulamentos de saúde e segurança apropriados que a Coca-Cola. É o mesmo para fabricantes de brinquedos e produtores de filmes. O direito de estar seguro, ou neste caso não ser prejudicado é absoluto e não depende do tamanho da organização da qual você está consumindo um produto ou serviço

Pergunta 28: Você tem alguma opinião sobre o conjunto de princípios estabelecidos no parágrafo 2.49 (proteção e garantia, liberdade de expressão, adaptabilidade ao longo do tempo, transparência, aplicação robusta, independência e proporcionalidade), e equilibrar as tensões que às vezes podem ocorrer entre eles?

- As propostas irlandesas reconhecem que este é um processo iterativo, portanto, aceite sentimentos de ser ágil e inovador. O foco da regulação está em conformidade com os códigos, ao invés do comportamento pessoal - mas ainda precisa de um local para educar para que esse comportamento seja abordado. A consulta atual da Comissão de Leis sobre crimes online também é uma intervenção interessante aqui, pois tais mudanças na lei criarão clareza jurídica e, portanto, cultural em torno do que é aceitável e do comportamento legal online

- As preocupações com a liberdade de expressão e de expressão podem ser tratadas por meio de termos e condições - portanto, pode haver um lugar onde suas opiniões extremas sejam bem-vindas - mas esta não é a plataforma apropriada para isso. Não sugerindo que você não pode expressar essas opiniões, mas simplesmente afirmando que não pode fazer isso nesta plataforma

- Reconhecimento dos desafios de verificação de idade para menores e margens de erro na garantia de idade e as limitações inevitáveis dessas tecnologias